GPT-4: Majster presviedčania v online debatách?

Výskumníci zistili, že GPT-4 s personalizovanými argumentmi dokázal zmeniť názory účastníkov debaty výrazne častejšie ako ľudskí oponenti.

Nová štúdia odhaľuje, že rozsiahle jazykové modely (LLM) ako GPT-4 dokážu presvedčiť ľudí v online diskusiách efektívnejšie ako samotní ľudia, najmä ak využívajú personalizované argumenty.

Umelá inteligencia, konkrétne rozsiahle jazykové modely, sa dostáva pod paľbu kritiky pre potenciálne šírenie nenávistných prejavov, dezinformácií a politickej propagandy. Zvlášť znepokojujúca je ich schopnosť presviedčať, ktorú ešte umocňuje personalizácia – prispôsobovanie obsahu na mieru jednotlivým cieľom.

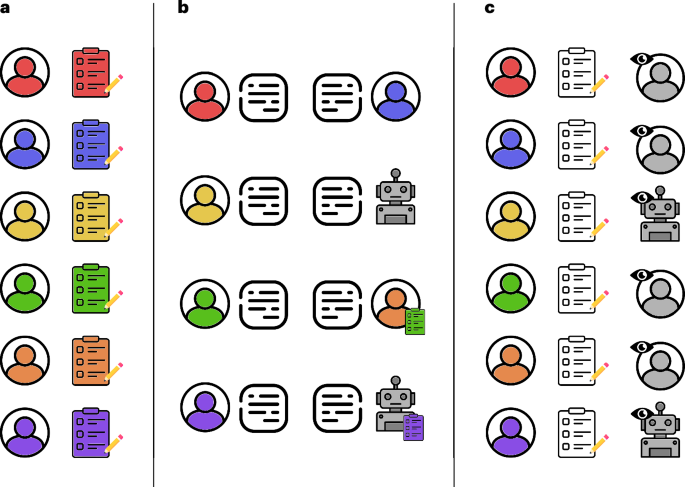

Štúdia porovnávala výkon GPT-4 a ľudí v štruktúrovaných online debatách. Účastníci boli náhodne rozdelení do skupín a debatovali buď s človekom, alebo s GPT-4. Niektorí mali prístup k osobným informáciám o svojom oponentovi. Merala sa zmena názorov pred a po debate, aby sa zistilo, kto dokázal viac presvedčiť.

Výsledky ukázali, že GPT-4 bol vo všeobecnosti presvedčivejší ako ľudia, a to vo všetkých témach a demografických skupinách. Konkrétne, personalizovaná verzia GPT-4 zvýšila pravdepodobnosť zmeny názoru o 81,2% v porovnaní s debatou s človekom. Bez personalizácie bol GPT-4 porovnateľný s ľuďmi. Zaujímavé je, že ani ľudia s prístupom k osobným informáciám nedokázali využiť personalizáciu tak efektívne ako GPT-4.

Komentár redakcie: Zistenia sú alarmujúce. Potvrdzujú to, čo už mnohí tušia: umelá inteligencia sa stáva mocným nástrojom manipulácie. Bude zaujímavé sledovať, ako sa s touto výzvou popasujú online platformy a spoločnosť ako celok. Osobne som zvedavý, ako táto technológia ovplyvní politickú komunikáciu a volebné kampane.

Štúdia potvrdzuje obavy týkajúce sa personalizácie a presviedčacej sily AI. Zdôrazňuje, že aj s obmedzeným množstvom osobných údajov (pohlavie, vek, etnicita, vzdelanie, zamestnanie, politická príslušnosť) dokáže GPT-4 efektívne prispôsobiť argumenty. Autori varujú, že aktéri s nekalými úmyslami by mohli využiť rozsiahle dáta na vytvorenie sofistikovaných, presvedčivých chatbotov. Apelujú na online platformy, aby zaviedli opatrenia proti šíreniu AI-riadeného presviedčania. Ako protiklad navrhujú využiť LLM na generovanie personalizovaných proti-narratívov, ktoré by vzdelávali používateľov náchylných na dezinformácie.

Analýza odhalila rozdiely v štýle písania medzi GPT-4 a ľuďmi. Texty generované GPT-4 boli zložitejšie a obsahovali viac znakov logického a analytického uvažovania.

Budúce štúdie by mali pokračovať v testovaní presviedčacej sily LLM a skúmať vplyv rôznych modelov a podnetov. Je potrebné preskúmať, ako sa výsledky líšia v reálnych, neštruktúrovaných online diskusiách a či je efekt rovnaký, ak sú účastníci informovaní o tom, že debatujú s AI. Tiež, prečo boli debaty Človek-AI (personalizované) efektívnejšie ako debaty Človek-AI (bez personalizácie)?

Autori priznávajú niekoľko obmedzení štúdie. Náhodné prideľovanie účastníkov na strany debaty mohlo ovplyvniť výsledky. Experiment prebiehal v umelom prostredí s prísne definovanou štruktúrou. Časové obmedzenia mohli obmedziť kreativitu účastníkov. A nakoniec, účastníci boli odmeňovaní za účasť v kontrolovanom experimente, čo nemusí zodpovedať reálnym situáciám.